OpenAI의 인재 유출: AI 안전성에 대한 우려와 미래

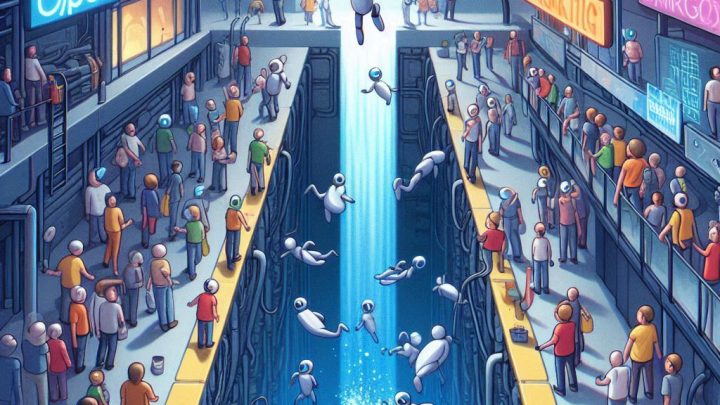

OpenAI가 또 한 명의 주요 AI 안전 연구원을 잃었습니다. 릴리안 웽(Lilian Weng) 전 연구 및 안전 부사장의 퇴사는 OpenAI가 직면한 심각한 인재 유출 문제와 AI 안전성에 대한 우려를 다시 한번 부각시키는 사건입니다. 이는 단순한 인력 감소를 넘어, AI 기술 발전의 윤리적, 사회적 영향에 대한 심각한 질문을 던져줍니다.

릴리안 웽의 퇴사와 그 의미:

웽은 7년간 OpenAI에서 근무하며 로봇 공학 팀부터 GPT 모델의 안전 시스템 개발까지 다양한 분야에서 중요한 역할을 수행했습니다. 그녀의 퇴사는 X(이전 Twitter)를 통해 발표되었으며, 7년간의 OpenAI 생활 후 새로운 도전을 모색하고자 한다는 내용이었습니다. 하지만 그녀의 퇴사는 단순한 개인적인 이유만으로 설명하기 어렵습니다. 최근 OpenAI에서는 웽을 포함한 수많은 주요 연구원 및 경영진의 퇴사가 이어지고 있으며, 이러한 엑소더스는 AI 안전성에 대한 OpenAI의 우선순위 설정에 대한 의문을 제기합니다. 많은 퇴사자들은 OpenAI가 상업적 목표를 AI 안전보다 우선시한다고 비판해 왔습니다.

AI 안전성에 대한 우려 증폭:

웽의 퇴사는 일리아 수츠케버(Ilya Sutskever), 얀 라이크(Jan Leike) 등 OpenAI의 다른 주요 인물들의 퇴사와 더불어, AI 안전성에 대한 심각한 우려를 낳고 있습니다. 이들은 모두 AI 안전 연구에 중요한 역할을 맡았던 인물들로, 그들의 동시다발적인 퇴사는 OpenAI의 AI 안전 전략에 심각한 문제가 있음을 시사합니다. 특히, "Superalignment" 팀 해체와 같은 사건들은 OpenAI가 장기적인 AI 안전 연구보다는 단기적인 수익 창출에 더 집중하고 있음을 보여주는 사례로 해석되고 있습니다.

OpenAI의 대응과 향후 과제:

OpenAI는 웽의 퇴사에 대해 공식적으로 "그녀의 획기적인 안전 연구와 엄격한 기술적 안전 장치 구축에 대한 기여에 깊이 감사한다"는 성명을 발표했습니다. 또한 안전 시스템 팀이 계속해서 중요한 역할을 수행할 것이라고 강조했습니다. 하지만 이러한 발표는 퇴사자들의 비판을 완전히 해소하기에는 부족하며, OpenAI가 AI 안전에 대한 신뢰를 회복하기 위한 실질적인 조치를 취해야 할 필요성을 강조합니다.

AI 기술 발전과 윤리적 고려:

OpenAI의 인재 유출 사태는 AI 기술 발전의 속도와 윤리적 고려 사이의 균형에 대한 중요한 질문을 제기합니다. 강력한 AI 시스템의 개발은 엄청난 잠재력을 가지고 있지만, 동시에 예측 불가능한 위험을 초래할 수 있습니다. 따라서 AI 기술의 개발과 함께 AI 안전성에 대한 지속적인 연구와 투자가 필수적이며, 단순히 상업적 이익을 추구하는 것만으로는 AI의 안전하고 윤리적인 발전을 보장할 수 없습니다.

AI안전성에 대한 논의는 단순히 기술적인 문제를 넘어, 사회적, 윤리적, 정치적 영역까지 확장되어야 합니다. OpenAI의 사례는 AI 기술의 발전 방향에 대한 사회적 합의 형성의 중요성을 보여주는 경종이라고 할 수 있습니다. 향후 OpenAI가 AI안전에 대한 진정성 있는 대응을 보여줄 수 있을지, 그리고 AI 업계 전체가 윤리적AI 개발에 대한 책임감을 갖고 나아갈 수 있을지 주목해야 합니다. OpenAI의 미래, 그리고 AI의 미래는 이러한 질문에 대한 답변에 달려 있습니다. 마지막으로, 인공지능 기술의 발전이 인류에게 이익이 되도록 하는 것은 우리 모두의 책임입니다.